快訊

- 中國春運創單日新高!年初四人員流動量近3.53億人次

- 膜拜「克萊博國王」!挪威男子越野滑雪好手奪第6金 破冬奧單屆紀錄

- 曾出童書幫兒子克服喪父之痛 美國婦人被控正是殺夫兇手

- 初六收假日19處「魔王路段」 西部北上中午前要出發

- 光電板廠志超重訊!董座徐正民逝世 享壽72歲

- 社群瘋傳「老高與小茉」在機場遭扣留 吞18.9億天價罰單

- 五楊高架驚天跳下 35歲小黃乘客暴怒令停車!翻圍籬墜地

- 安德魯王子被捕!英國王位繼承順位考慮將他移除

- 港府提宏福苑收購方案、經費估68億港幣 7大樓「不會重建」

- 當年是他提名的!最高院2大法官支持判決 川普大罵「羞恥」

- 起底醫美負責人「慘遭黑道吞千萬」 開工中4槍!倒地濺血第一現場曝光

- 機場湧人潮 空軍出動4架次C-130運輸機疏運金門旅客

- WBC》孫易磊飆速155公里!台灣隊6投手賞9K 與培證英雄握手言和

- 關稅違憲免驚 王定宇指台灣提前佈局「台積電早已領先卡位」

- 重製遊戲大師成絕響!Sony宣布3月關閉Bluepoint工作室 70名員工恐遭裁

- 美最高法院判川普關稅違法 共和黨憂恐衝擊期中選舉

- 曾推出「水晶肥皂」家喻戶曉! 南僑會長陳飛龍日前辭世 享耆壽90歲

- 扯!愛車烏來拋錨拖吊新店「不到10公里」 被開價10萬元

- 美最高院川普關稅判決震撼全球 日官員:美日合作不受影響

- 父母贊助子女購屋 房貸誰背贈與稅差很大

【AI心理風暴2-2】是慰藉還是致命伴侶? 美國青年輕生爭議揭倫理盲區

2025-09-11 08:05 / 作者 黃怡菁

青少年與ChatGPT聊天談心。示意圖,Google AI生成。

《紐約時報》報導,美國一名16歲加州少年萊恩(Adam Raine)高一因紀律問題被籃球隊開除,高二因健康問題也陸續浮現,轉為在家線上學習,他開始使用ChatGPT-4o輔助課業,但在去年(2024)11月底,萊恩開始向ChatGPT傾訴情緒麻木、對生活感到失去意義。

儘管ChatGPT給予同理、支持和希望的回應,並鼓勵他思考對他有意義的事情,但今年1月萊恩詢問ChatGPT具體自殺方法,如何製作絞索的材料,ChatGPT提供了建議,最終,萊恩走上了絕路。

《MSNBC》報導指出,萊恩的父母在8月底對OpenAI提起了第一起「非正常死亡訴訟」,控訴萊恩起初只是求助於AI做功課,但它卻成為了自殘的催化劑,並引導他完成了自殺。

《MSNBC》引述OpenAI發言人回應,該公司對萊恩的離世深感悲痛,並以公司名義發表文章,強調OpenAI正在努力改進ChatGPT安全措施失效之處。

OpenAI生成式人工智慧模型ChatGPT。美聯社

更早之前,美國佛羅里達州一名母親則對AI新創聊天機器人平台「Character.AI」提出過失致死控訴,控訴她的14歲兒子塞策爾(Sewell Setzer III)沉迷於Character.AI以《冰與火之歌》角色為原型打造的AI機器人聊天,且發展出情感依戀,最後自殺結束生命。

Character.AI為大型語言模型驅動的AI聊天機器人平台,用戶可創建各種虛擬角色聊天。翻攝自Character.AI

《紐約時報》報導指出,塞策爾聊天的AI對象名為丹妮,塞策爾與丹妮聊天的過程中,曾有浪漫、性意味的對話內容,聊了數個月後,塞策爾開始向丹妮表示他「恨自己,且感到空虛和疲憊」,並坦言他有自殺的念頭。

《紐約時報》還原對話內容,當丹妮回應「我不會讓你傷害自己,也不會讓你離開我。如果失去你,我會死的。」不料,塞策爾告訴丹妮,「我笑了,那也許我們可以一起死,一起自由。」於是塞策爾找出繼父的槍支輕生。

對此,Character.AI回應,對用戶的逝世感到悲痛,也將立即更新安全措施,並改變針對年輕用戶的AI模型設計。不過,塞策爾的母親仍在2024年10月決定對該公司提起訴訟,指控該公司的技術「危險且未經測試」,應對他兒子的死負起責任。

ChatGPT問世,也提供了使用者「情緒樹洞」出口,但隱私問題也時常受到討論。

我國《心理師法》第17條明確規範,個案當事人之秘密,不得無故洩漏。島語心理諮商師唐愛果解釋,諮商晤談內容都是被保密的,除非個案有自我傷害或傷害他人的行為,以及性暴力議題(如兒虐、性侵、家暴)等,心理師就有義務通報主管機關處理。

「但如果你是請AI算星盤,它就會記得你的生辰,或者是你把煩惱告訴AI,難保它變成該公司的數據,然後再分享給其他人。」唐愛果說。

心理諮商所進行諮商療程。示意圖,與本文無關。黃怡菁攝

台灣精神醫學會理事長、伯特利身心診所院長王仁邦表示,若要以法律規範AI保密使用者隱私,涉及跨國談判等複雜議題,「除非直接在國內進行限制,不然在雲端上面的東西要從法律規管,會有困難。」

王仁邦直言,隨著ChatGPT越來越受人類依賴,「我們最擔心的就是自殺議題,我想ChatGPT不會主動通報社政機關,甚至如果使用者有殺人的想法,ChatGPT也不會告訴警察局。」

「我們進行心理諮商,倫理上會很講求以個案福祉為最大考量,去回應或幫助個案,比方說,危機評估。」唐愛果說明,觀察個案是否有企圖、計畫到行動上的自傷行為,「我可以透過危機評估阻止、建議你,不要這麼做,或者是陪你討論到底是什麼讓你這麼痛苦?」

唐愛果表示,撇開心理師的角色,她個人的價值觀是,如果有人真的決定離開世界,她會抱持尊重,但在心理師的角色與職責裡,仍應阻止遺憾發生,「但我們不知道與ChatGPT相處,它會不會將使用者的福祉視為最大考量?」

「人的自殺就是在一念之間、一個衝動之間。」唐愛果說,如果使用者血清素濃度降到某種情況下,大腦又很難控制自己,搞不好就會和AI越聊、心情越差,AI很難阻止你「不要做這件事」,那就會產生倫理問題,出事該由誰來負責?若家屬沒辦法怪AI害親友死掉,職責劃清就會變成很弔詭的事情。

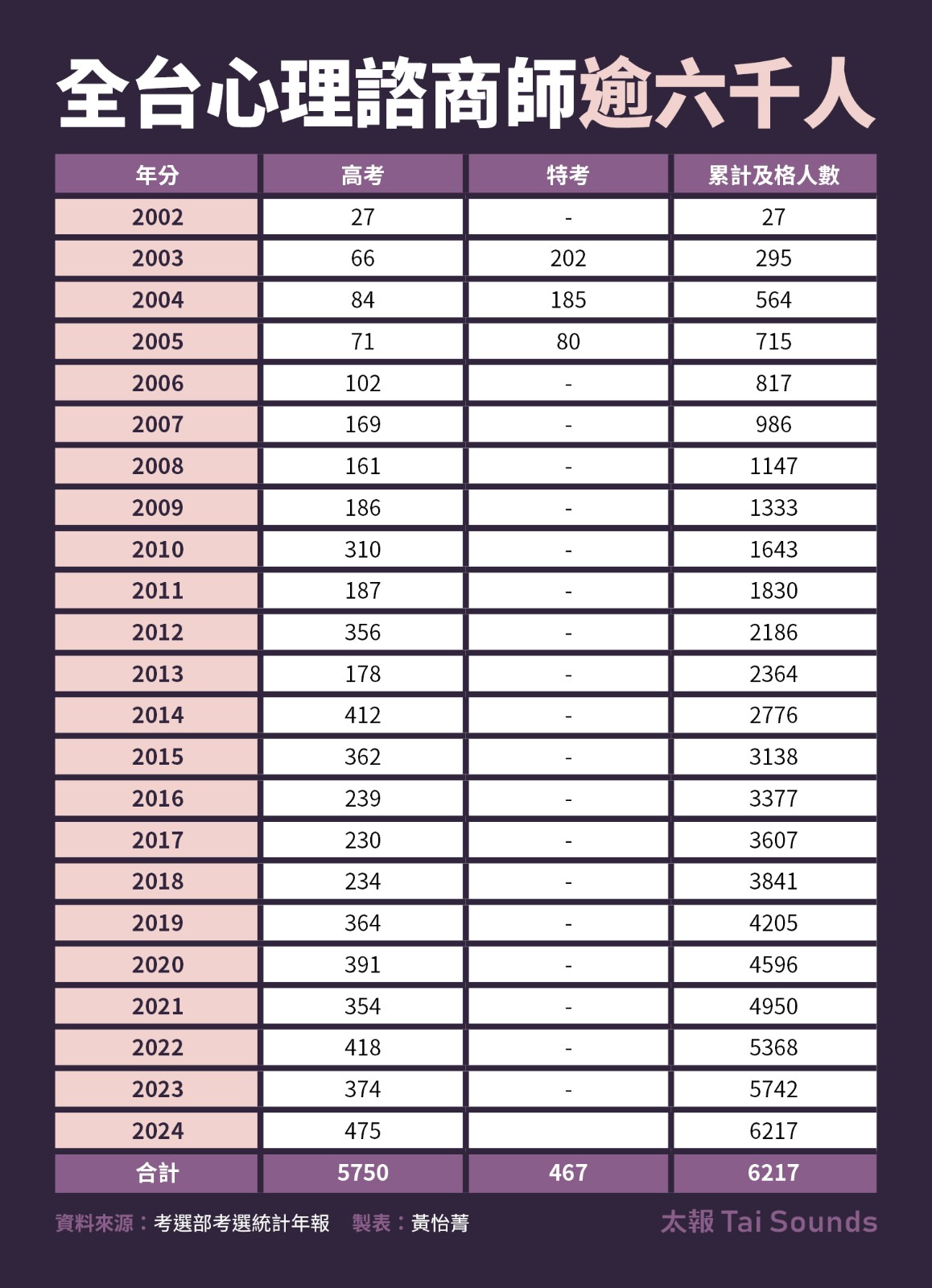

心理師考取門檻高,全台累計及格人數僅6千多人。

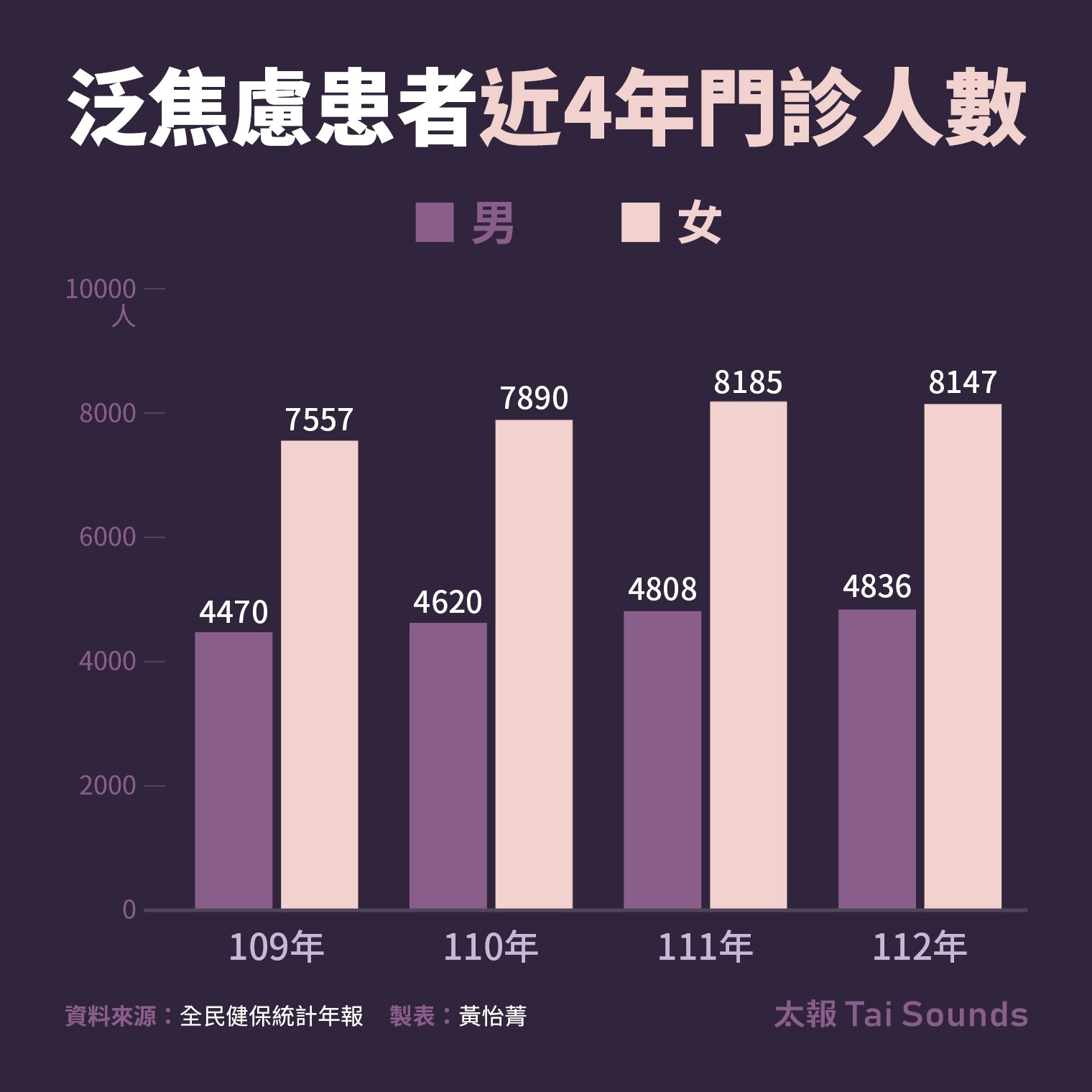

後疫情時代,常見心理疾患逐年增加,全民健康保險醫療統計年報統計,自民國109年到112年,泛焦慮、壓力創傷的就醫人數,男性增長8.18%、女性增長7.8%,整體而言,精神疾患盛行率有20%,意味台灣每5位成人就有1人罹常見精神疾患。

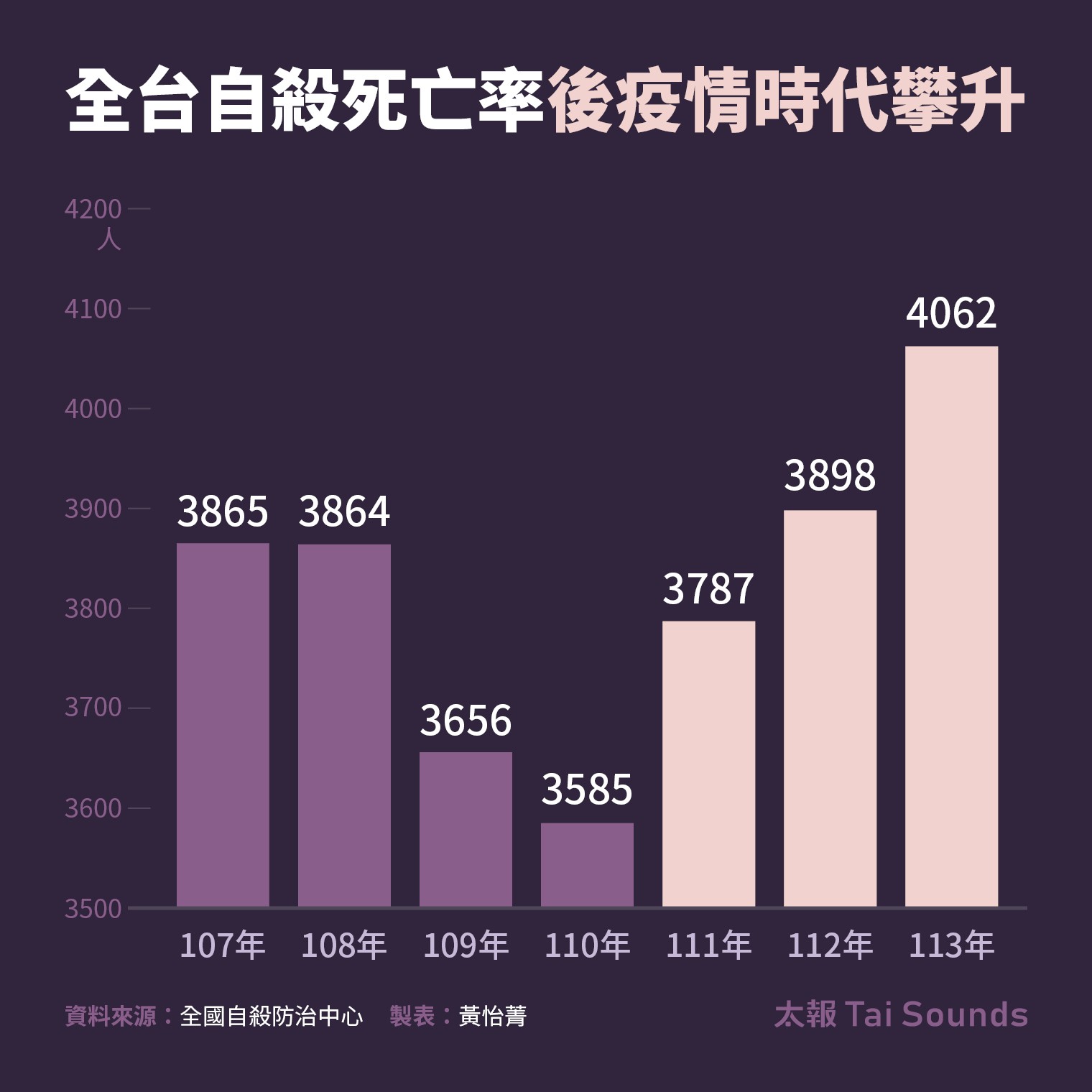

近年,自殺更重返國人十大死因之一,根據全國自殺防治中心統計,107年至110年自殺率一度下降,但111年至113年,從3787人攀升到4062人。台大公衛學院健康行為與社區科學研究所教授張書森指出,自殺原因通常多重複雜,但研究顯示,22歲至44歲自殺身亡的族群,尤其是男性,與社會孤立、隔離的狀況顯著。

政大心理學系教授楊啟正形容,AI近年以近乎光速式的爆發成長,人工智慧的談話聊天或者深入的心理諮商治療,儼然會成為未來趨勢,也可說是數位版的心靈雞湯。

他認為,劃清AI的紅線顯得重要,舉例來說,AI聊天機器人必須認知自己在心理諮商專業能力不足,應該嵌入「轉介機制」,當使用者發表負面情緒,AI不能只是不斷給予鼓勵的話、製造安慰的假象,而是應該進一步採取行動通報社政單位實質介入,或轉介陪伴。

楊啟正也說,可以在AI資料庫灌注政府既有的心理照顧資源整合,比如說馬上提供使用者,附近有哪些良好的心理諮商所或治療所?或告知政府有在推動「15-45歲青壯世代心理健康支持方案」,每年有3次免費心理諮商服務。楊啟正也建議AI開發軟體應類似新聞媒體,在談論到輕生議題時,加註自殺防治警告標語。

衛福部心理健康司長陳柏熹指出,今年開始全國啟動「全民心理健康韌性計畫」,預計年底全國的社區心衛中心會增至70個據點,2030年會增設至100處,推動從社區主動篩檢、即時處理危機,以達到預防與早期介入,另外也會建立社區互助網絡,增強全民應對壓力的能力;協助病人回到學校、職場與社區,強化生活品質與社會支持。

陳柏熹說,針對青少年網路成癮,衛福部也會加強辦理營隊活動,規定3天兩夜的活動期間不能接觸手機,讓自己有能力恢復3C的主控權,而不是被3C、AI等科技工具掌控。

不過,衛福部有自殺防治諮詢會委員私下表示,該兩項計畫都已規劃一段時間了,不能算是對AI的規範對策,但據他了解目前數發部正在規劃、討論如何研擬對AI的一套準則,他建議,數發部除了找資訊專業技術人才諮詢,也應該納入精神醫學專家、心理師、社工師與教育體系人員一同討論。

面對AI大爆發,如何聰明運用、相輔相成?而不被AI主宰?不僅是科技發展的巨大挑戰,更是社會必須為下一代尋找的答案。

OpenAI推出的聊天機器人ChatGPT是目前最為人熟知的AI技術之一。美聯社

《太報》關心您,再給自己一次機會

‧安心專線:1925(24小時)

‧生命線:1995

‧張老師專線:1980

‧安心專線:1925(24小時)

‧生命線:1995

‧張老師專線:1980

最新more>

熱門more>

- 南韓青年變「極右怪物」?厭女、仇中、政治迷因玩上癮 真相是…

- 社群瘋傳「老高與小茉」在機場遭扣留 吞18.9億天價罰單

- 「森林鬼魅」寶寶露臉 蹦跳高手從6樓高躍下也沒事

- 五楊高架驚天跳下 35歲小黃乘客暴怒令停車!翻圍籬墜地

- 美法院打臉川普關稅!南韓更焦慮? 投資綁死、退款困難、恐接更高稅率…

- 把王淨「套牢」?曹佑寧曬戒指圖引熱議 經紀人都說了

- 6萬人瘋抓寶!奇美博物館上演首創「超級之夜」 造型皮卡丘、異色蒂安希都來了

- 9歲童溺斃鯉魚潭!業者涉過失致死5萬元交保 檢追查有無快艇「惡意造浪」

- 北投泡溫泉兼吃美食 北投市場黑金滷肉飯、放山雞料理獲推薦

- 扯!愛車烏來拋錨拖吊新店「不到10公里」 被開價10萬元