快訊

- 川普再提「可能今年訪中」 中國外交部打太極:中美元首保持密切交往溝通

- 執政黨淪在野黨 南韓議員當選「國民力量」黨魁、誓言打倒李在明

- 盧特尼克示意 美國政府也考慮取得國防企業股份

- 聲押大戰!「小英男孩」鄭亦麟涉綠能弊案收賄 北院今晚10點半開庭

- 搶攻企業戰場! 高通推全球首款全面整合RFID功能處理器Dragonwing Q-669

- 【一文看懂】逼迫聯準會降息、開除聯準會理事為何非比尋常

- 新北深坑回收場竄火冒濃煙 消防緊急籲「門窗緊閉、戴口罩」

- 輝達企業級AI 伺服器RTX PRO上陣 台積電搶先用、鴻海仁寶電子五哥全到齊

- 獲韓美總統「加持」 南韓手工筆品牌聲名大噪、概念股暴漲

- 台東基地大雨跑道濕滑 空軍:勇鷹高教機放捕捉勾攔截鋼纜平安降落

- 英前保守黨魁認中國曲解聯大2758解釋 多議員欲促政府推動台灣國際參與

- 描繪荷蘭半導體巨擘ASML崛起故事!《造光者》9/3出版 作者將親飛來台

- 「比颱風還猛」高雄雷雨狂炸 冷心低壓發威!氣溫驟降近10度

- 大雷雨狂炸高雄! 旗津逾3000戶停電「饋線跳脫」台電搶修中

- 澳洲偏僻小鎮爆槍擊案 10警登門搜索、兇嫌槍殺2人後逃逸

- 飛安意外! 台東志航基地勇鷹高教機「煞不停」險衝出跑道

- 中國九三大閱兵 將展出多款阻止美軍介入台海衝突的武器

- 出席IPAC晚宴 蕭美琴:台灣人有傷痕有挫折但沒有放棄的權利

- 林憶君批過去治水預算無效「打水漂」? 卓榮泰:若無預算大家恐更痛苦

- 綠委接力轟柯建銘假傳聖旨、恣意濫權 朱立倫:柯續留立院對不起台灣社會

輝達企業級AI 伺服器RTX PRO上陣 台積電搶先用、鴻海仁寶電子五哥全到齊

2025-08-26 21:00 / 作者 陳俐妏

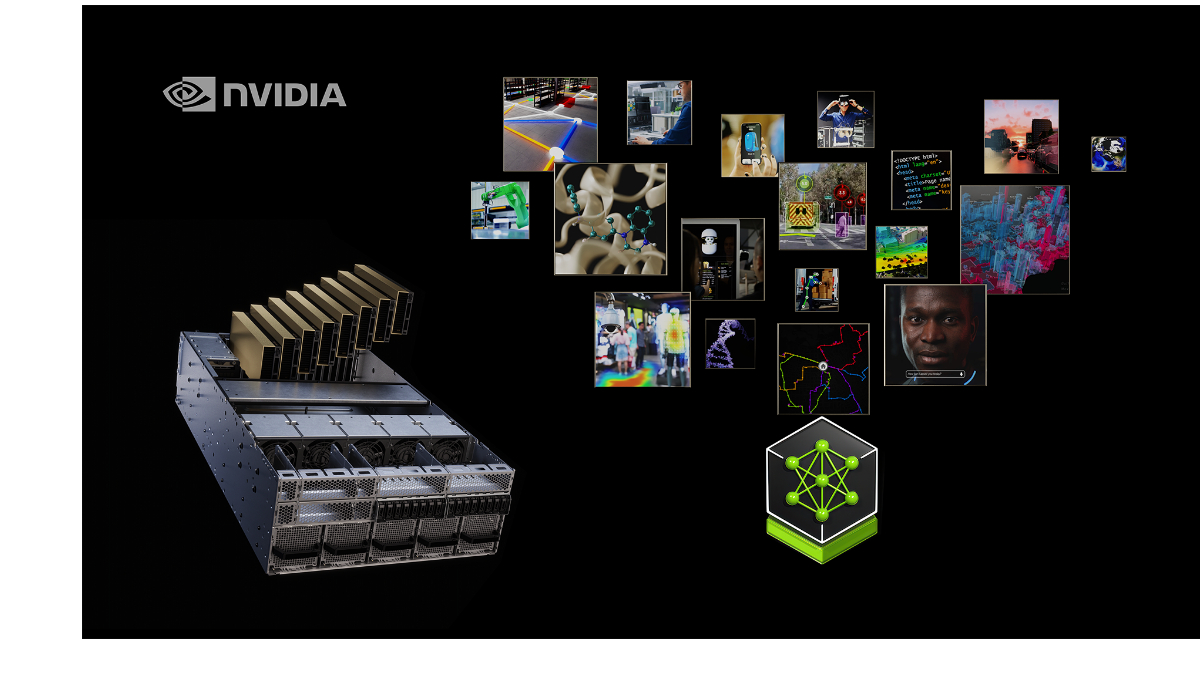

輝達推出企業級AI伺服器RTX PRO。資料照

AI霸主輝達繼推出機器人新大腦後,黃仁勳預告的「規模最大」的企業級AI伺服器RTX PRO 伺服器也正式上陣,採用全新 RTX PRO 6000 Blackwell 伺服器版本 GPU,較H100 GPU提升3倍,對比傳統CPU伺服器效能提升更達45倍, 迪士尼、鴻海、日立、現代汽車、禮來、SAP 及台積電等全球領導企業率先採用,將加速 AI 推理、物理 AI 與企業工作負載。輝達伺服器台廠供應鏈,包括:鴻海、神達、華碩、和碩、英業達、仁寶、技嘉、緯創、研華等也全數入列,也是首次電子五哥全數到齊。

輝達執行長黃仁勳表示,AI 時代已經來臨,企業無法再單依靠傳統伺服器,而是必須為 AI 重新設計架構。輝達RTX PRO 正是專為此刻而打造的運算平台,既能執行現今的 IT 工作負載,同時又能驅動將徹底改變每家公司、每個產業的 AI 代理。

台積電董事長魏哲家表示,半導體是 AI 的支柱,其推動的突破性發展正在重新定義各行各業。透過與輝達的緊密合作,台積電正以 Blackwell 驅動的 AI 工廠推進半導體製造,並最佳化晶圓廠營運,包括採用最新的 RTX PRO 伺服器,進一步提升整個產業的效率與創新。

黃仁勳在今年COMPUTEX展預告將推出「規模最大」、「銷售通路最廣泛」企業級AI 伺服器RTX PRO Server,從對外公布的資訊,輝達在台灣的伺服器供應廠商,皆已準備陸續量產該產品。

輝達最新公布NVIDIA RTX PRO 伺服器提供多種配置,搭載 RTX PRO 6000 Blackwell 伺服器版本 GPU,包括 Cisco、Dell Technologies、HPE、Lenovo 與 Supermicro,以及研華、安提國際、Aivres、永擎電子、華碩、仁寶、Eviden、鴻海、技嘉、英業達、神達、微星、和碩、雲達、緯創以及緯穎等。電子五哥全數入列。

RTX PRO Server 最多可支援8張輝達最新RTX PRO 6000 Blackwell伺服器版GPU,等於一台RTX PRO Server系統就擁有近20萬個GUDA運算核心和高達800 GB記憶體,記憶體頻寬每秒高達13TB。

NVIDIA Llama Nemotron Super 推理模型在單顆 NVIDIA RTX PRO 6000 GPU 上以 NVFP4 運行時,與在 H100 GPU 上以 FP8 運行時相比,性價比表現最高可提升 3 倍。這使得在更低成本下即可實現更準確的推理。

為開發高效的物理 AI 系統,企業需要先在模擬環境中測試與最佳化其機器人車隊,再部署至實際工廠。NVIDIA RTX PRO 伺服器正透過為數位孿生、模擬及合成資料生成等工作流程,提供相較搭載 NVIDIA L40S GPU 的系統高出最多 4 倍的效能,進一步推動工業 AI 與物理 AI 發展。各大企業採用 NVIDIA RTX PRO 伺服器,無需全面改造既有資料中心,也能從通用運算叢集轉型至 AI 工廠基礎設施。

最新more>

- 川普再提「可能今年訪中」 中國外交部打太極:中美元首保持密切交往溝通

- 《左撇子女孩》進擊釜山影展 蔡淑臻一見面就跟童星道歉

- 執政黨淪在野黨 南韓議員當選「國民力量」黨魁、誓言打倒李在明

- 盧特尼克示意 美國政府也考慮取得國防企業股份

- 《花甲少年趣旅行》劇組車禍!箱型車暴衝撞裂電杆 5人緊急送醫

- 聲押大戰!「小英男孩」鄭亦麟涉綠能弊案收賄 北院今晚10點半開庭

- 舒淇《女孩》通殺3大影展 帶新手奶爸邱澤飛威尼斯搶金獅

- 女偶像「抖J奶」逛鐮倉老街 民眾驚呼太扯!市府出手了

- 搶攻企業戰場! 高通推全球首款全面整合RFID功能處理器Dragonwing Q-669

- 【一文看懂】逼迫聯準會降息、開除聯準會理事為何非比尋常

熱門more>

- 「酒+毒+藥」舞廳女開奧迪撞死人…IG飆髒話還嗆「沒關係」 國民法官判她8年6月

- 小英男孩涉綠能弊案!鄭亦麟疑收賄遭聲押 雙親也各以10萬交保

- 獨/新規開倒車?高雄派出所長「休假排行榜」上線...基層炸鍋 警:內部參考

- 《角頭-鬥陣欸》4天劫7720萬 王識賢收履歷合照抵薪水

- 「情色教主」雪碧出事! 身體「這1處」閉不起來…無人敢碰

- 【錢進海外-日本篇2-2】進場容易退場難 專家揭日本購屋三大誤區

- 獨/16槍命案目擊者回憶驚魂瞬間…神秘男闖校園奔逃 黑衣變淺衣躲追緝

- 中颱劍魚開眼成「西太平洋風王」 上看強颱預計巔峰狀態登陸越南

- 宣明智告它詐欺!華盛黑歷史曝光 綁女官員強拍裸照逼放水

- 停車未拉手煞車?沿路下滑…圖肉身擋車 屏東運將捲車底亡